14 лучших инструментов для веб-скрейпинга для извлечения данных в 2026 году

Веб-скрейпинг может быть полезен для различных целей, таких как исследование рынка, анализ данных, агрегация контента, сравнение цен, мониторинг изменений на веб-сайтах и многих других. Рассмотрим 14 лучших инструментов для веб-скрейпинга для извлечения данных в 2026 году.

Содержание

Что такое веб-скрейпинг?

Веб-скрейпинг — это техника, используемая для автоматического извлечения данных с веб-сайтов. Это включает написание программы или использование инструмента для доступа и извлечения информации с веб-страниц, как правило, в структурированном формате, таком как HTML или XML. Инструменты для веб-скрейпинга позволяют пользователям собирать большое количество данных с нескольких сайтов, которые затем могут быть проанализированы, обработаны или использованы для различных целей.

14 лучших инструментов для веб-скрейпинга

|

Инструменты для веб-скрейпинга |

Начальная цена |

Поддержка JavaScript |

Ротация IP |

|

75 $ в месяц |

✔️ |

✔️ |

|

|

Бесплатный |

✔️ |

X |

|

|

189 $ в месяц |

✔️ |

✔️ |

|

|

199 $ в месяц |

✔️ |

✔️ |

|

|

50 $ в месяц |

X |

✔️ |

|

|

Бесплатный |

X |

✔️ |

|

|

Бесплатный |

✔️ |

✔️ |

|

|

Индивидуальная |

✔️ |

✔️ |

|

|

Индивидуальная |

X |

✔️ |

|

|

$49 в месяц |

✔️ |

✔️ |

|

|

$99 в месяц |

✔️ |

✔️ |

|

|

$299 в месяц |

✔️ |

✔️ |

|

|

$99 в месяц |

✔️ |

✔️ |

|

| Беплатный/$49 |

✔️ |

✔️ |

1. Octoparse

Стоимость

- Бесплатный план: Предоставляет ограниченные возможности и позволяет использовать 10 парсеров.

- Стандартный план: Стоимость около 75 долларов в месяц. Этот пакет позволяет неограниченное количество парсеров, ротацию IP и доступ к API.

- Профессиональный план: Стоимость около 209 долларов в месяц. Этот пакет подходит для крупномасштабного извлечения данных и включает все функции стандартного плана плюс очереди с приоритетом, высокоскоростное извлечение и многое другое.

Основные функции

- Экспорт данных: Octoparse поддерживает экспорт извлеченных данных в различные форматы, такие как CSV, Excel, HTML, TXT и базы данных (MySQL, SQL Server и Oracle).

- Продвинутый инструмент регулярных выражений: Этот инструмент помогает справляться с более сложными ситуациями при парсинге данных.

- Шаблоны для веб-парсинга: Octoparse предоставляет отформатированные шаблоны для парсинга данных с конкретных сайтов, таких как Amazon, eBay, Twitter и др.

- Решение CAPTCHA: Модуль может автоматически обрабатывать некоторые типы CAPTCHA в процессе парсинга.

Плюсы

- Ротация IP;

- Продвинутое извлечение данных;

- Планируемое извлечение;

- Широкие возможности экспорта.

Минусы

- Ограничения с динамическими сайтами;

- Скорость;

- Ограниченное решение CAPTCHA.

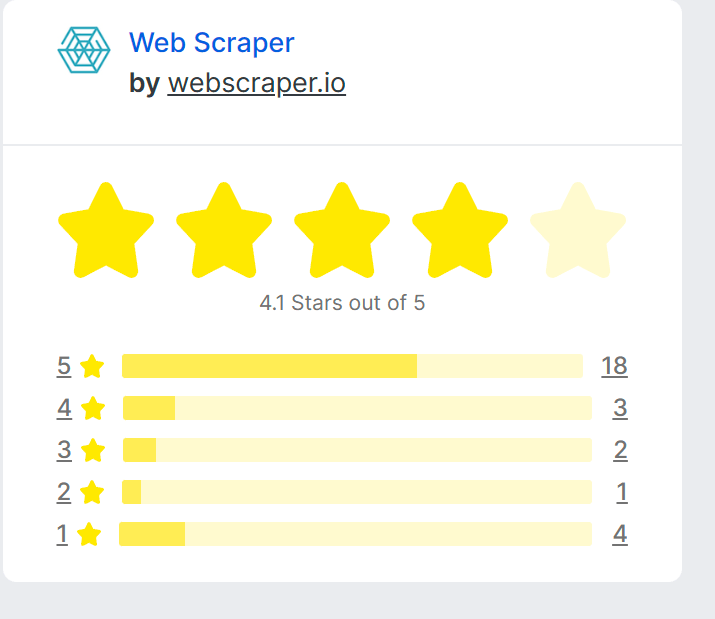

Рейтинг

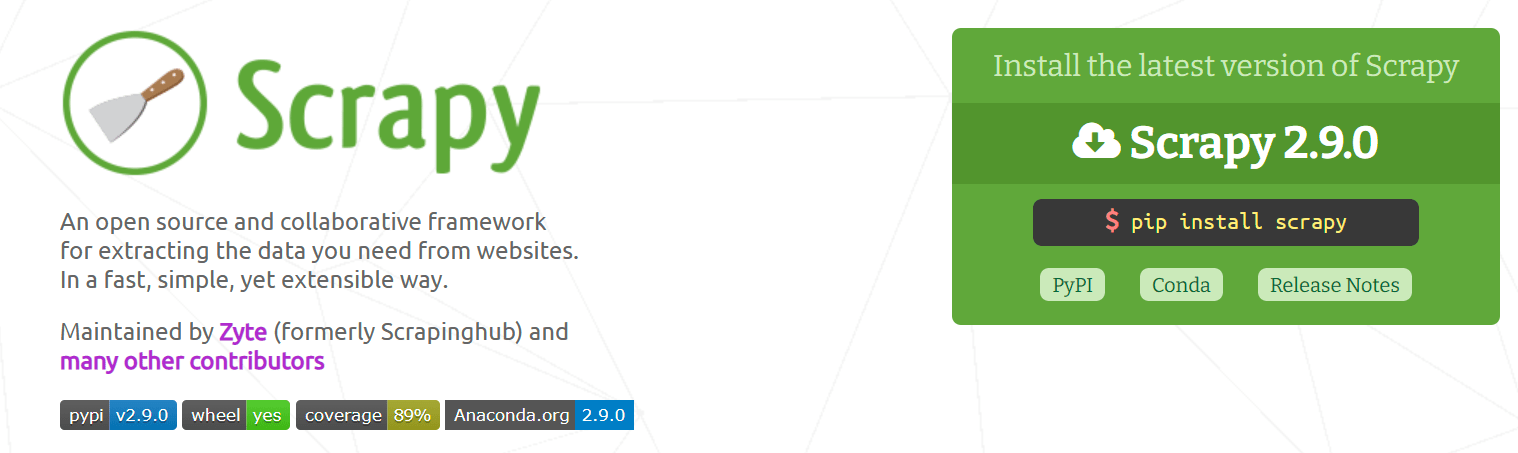

2. Scrapy

Цены

Scrapy — это фреймворк с открытым исходным кодом, используемый для веб-парсинга на языке Python. Как инструмент для веб-парсинга с открытым исходным кодом, он бесплатен для всех, кто хочет его скачать и использовать.

Основные функции

- Встроенное следование ссылкам: Scrapy может автоматически следовать за ссылками, основываясь на заданных правилах, что помогает в навигации для извлечения данных.

- Инструмент командной строки: Предлагает инструмент командной строки для управления процессом парсинга. Инструмент предоставляет команды для создания новых проектов, парсеров, анализа URL и т. д.

- Надежные конвейеры обработки данных: Обеспечивает мощные способы очистки и проверки извлеченных данных с использованием своих конвейеров.

- Встроенные функции HTTP: Инструмент для парсинга поддерживает такие функции, как аутентификация, работа с cookies, повторные попытки при неудачных запросах и другие.

- Экспорт данных: Обеспечивает встроенную поддержку вывода собранных данных в различных форматах, таких как JSON, XML и CSV.

Плюсы

- Расширяемость;

- Сообщество и поддержка;

- Экспорт данных.

Минусы

- Менее интуитивно для одностраничных приложений;

- Отсутствие графического интерфейса пользователя;

- Требуется настройка и обслуживание.

Рейтинг

3. ParseHub

Цены

- Бесплатный план: Бесплатный план ParseHub предоставляет ограниченные функции и позволяет до 200 страниц за один запуск и 5 публичных проектов.

- Стандартный план: Этот план стоит примерно $189 в месяц и позволяет до 10 000 страниц за один запуск и 20 частных проектов.

- Профессиональный план: Этот план стоит около $599 в месяц и предоставляет неограниченное количество страниц за один запуск и 120 частных проектов.

- Корпоративный план: Для крупных компаний или кастомных требований инструмент для парсинга предлагает корпоративный план, который предоставляет более значительные возможности для извлечения данных, отличную поддержку и индивидуальные решения. Цена этого плана не указана и, вероятно, может обсуждаться в зависимости от специфических потребностей пользователя.

Основные функции

- Экспорт данных: Поддерживает экспорт собранных данных в нескольких форматах, включая CSV, Excel и JSON, или через их API.

- Доступ к API: Обеспечивает API, который можно использовать для управления и запуска своих проектов программным способом.

- Парсинг нескольких страниц: С помощью программного обеспечения для парсинга можно установить правила для перехода по ссылкам и парсинга нескольких страниц для полного извлечения данных.

- Условная логика: ParseHub позволяет внедрять условную логику в настройку парсинга, что позволяет обрабатывать различные сценарии парсинга.

- Облачная архитектура: Это облачный инструмент, что означает возможность настроить проекты на выполнение и затем закрыть компьютер, не прерывая процесс извлечения данных.

Плюсы

- Запланированные запуски;

- Облачная архитектура;

- Продвинутые селекторы.

Минусы

- Доступ к API;

- Скорость;

- Ограниченный бесплатный план.

Рейтинг

4. Import.io

Цены

- Начальный пакет: Создан для малого бизнеса и индивидуальных пользователей с базовыми потребностями в парсинге.

- Стандартный пакет: Предназначен для извлечения информации с интерактивных сайтов и обхода CAPTCHA и барьеров входа.

-

Расширенный пакет: Разработан для эффективного извлечения больших объемов данных, с учетом самых приоритетных сценариев использования с обширной поддержкой.

- Кастомный: Ориентирован на крупные корпорации с потребностями в высокообъемном извлечении данных и требованиями к расширенным функциям и приоритетной поддержке.

Основные функции

- Обеспечение качества данных: Предлагает функции обеспечения качества данных, которые гарантируют, что данные, которые вы извлекаете, точные и полные.

- Планирование и автоматизация: Программное обеспечение для веб-скрапинга позволяет вам запланировать задачи по извлечению данных на определенные интервалы, что полезно для проектов, где требуются регулярные обновления данных.

- Доступ через API: Предоставляет API, который вы можете использовать для управления и выполнения ваших проектов программно или для интеграции извлеченных данных непосредственно в ваши приложения.

- Вебхуки: Вебхуки позволяют доставлять данные в реальном времени, означая, что ваши данные отправляются на ваш конечный пункт назначения, как только они будут готовы.

Плюсы

- Планирование и автоматизация;

- Доступ через API;

- Облачное решение.

Минусы

- Цена;

- Кривая обучения;

- Поддержка клиентов.

Рейтинг

5. Web Scraper

Цены

- Расширение для браузера Web Scraper: Это бесплатный инструмент, доступный в виде расширения для браузера Chrome. Он позволяет настраивать и выполнять небольшие и средние задачи по извлечению данных в вашем браузере.

- Проект: $50 в месяц.

- Профессиональный: $100 в месяц.

- Бизнес: $200 в месяц.

- Масштаб: от $300 в месяц.

Основные функции

- Многостраничное извлечение данных: Web Scraper может переходить по нескольким страницам сайта для извлечения данных и также управлять сайтами, использующими бесконечную прокрутку.

- Структура на основе карты сайта: Инструмент для веб-скрапинга структурирует ваш проект по извлечению данных как карту сайта, где вы можете определить, какие страницы посещать, какие данные извлекать и как страницы взаимосвязаны.

- Экспорт данных: Web Scraper поддерживает экспорт извлеченных данных в различных форматах, включая CSV.

- Облачное извлечение данных: С облачным сервисом (платная функция) вы можете масштабировать ваши задачи по извлечению данных и выполнять их на серверах Web Scraper, экономя ресурсы вашего компьютера.

Плюсы

- Поддержка многостраничного извлечения данных и бесконечной прокрутки;

- Облачное извлечение данных;

- Экспорт данных.

Минусы

- Ограниченные функции в бесплатной версии;

- Отсутствие рендеринга JavaScript в бесплатной версии;

- Кривая обучения.

Рейтинг

6. Beautiful Soup

Цены

Beautiful Soup — это библиотека с открытым исходным кодом для Python, используемая для веб-скрейпинга, чтобы извлекать данные из HTML и XML файлов. Она доступна бесплатно для использования и модификации. Нет никаких затрат на использование Beautiful Soup.

Как и в случае с любым инструментом с открытым исходным кодом, хотя сама библиотека бесплатна, возможны сопутствующие расходы в зависимости от того, как вы ее используете. Например, вам может понадобиться вложить время в изучение работы с библиотекой или оплатить вычислительные ресурсы, если вы занимаетесь крупномасштабным извлечением данных.

Основные функции

- Легкая навигация: Инструмент веб-скрейпинга преобразует сложный HTML-документ в дерево Python-объектов, таких как теги, навигационные строки или комментарии. Вы можете перемещаться по этому дереву и находить нужные данные.

- Поиск по дереву разбора: Beautiful Soup предоставляет методы и питоновские идиомы для поиска по дереву разбора. Вы можете фильтровать элементы по их тегам, атрибутам, текстовому содержимому или отношениям к другим элементам.

- Изменение дерева разбора: Программное обеспечение для веб-скрейпинга позволяет модифицировать дерево разбора или отдельные элементы в дереве разбора. Это означает, что вы можете изменять имена тегов и значения атрибутов, добавлять новые теги, изменять .string и .contents, использовать replace_with() и insert() и многое другое.

- Печать дерева разбора: Он предоставляет методы для красивой печати дерева разбора с форматированием или без него.

- Фильтры разбора: Он поддерживает сложные шаблоны и методы для поиска по дереву разбора. Вы можете использовать функцию, регулярное выражение, список или строку для фильтрации во время поиска.

Плюсы

- Открытый исходный код;

- Хорошо документирован;

- Сообщество.

Минусы

- Требуется знание программирования;

- Скорость;

- Нет поддержки JavaScript.

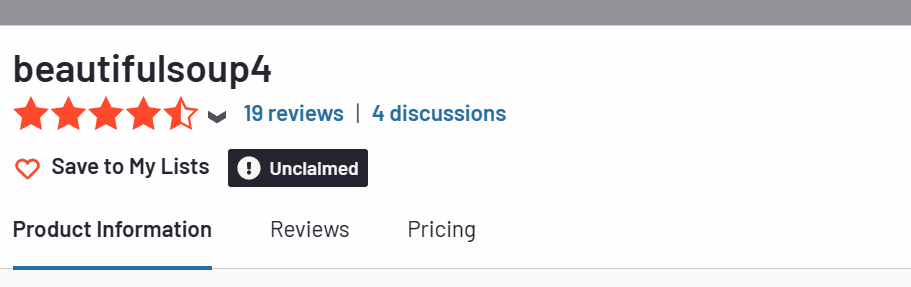

Рейтинг

7. Selenium

Цены

Selenium — это свободный и с открытым исходным кодом фреймворк для автоматизированного тестирования, используемый для проверки веб-приложений в разных браузерах и платформах. Он бесплатен в использовании, но вы также можете изменить его исходный код для своих нужд благодаря его природе с открытым исходным кодом.

Тем не менее, хотя сам Selenium бесплатен, с его использованием могут быть связаны некоторые косвенные расходы:

- Время на изучение и разработку.

- Затраты на инфраструктуру.

- Затраты на поддержку.

Основные функции

- Selenium Grid: Программное обеспечение для веб-скрейпинга позволяет запускать параллельные тесты, где различные тесты могут выполняться одновременно на различных удаленных машинах. Это помогает сократить время на выполнение параллельных тестов и способствует получению более быстрого обратного отклика.

- Интеграция с другими инструментами: Легко интегрируется с такими инструментами, как TestNG и JUnit для управления тест-кейсами и генерации отчетов. Этот инструмент также может быть интегрирован с Maven, Jenkins и Docker для непрерывного тестирования.

- Поддержка сообщества: Имеет широкую пользовательскую базу и активное сообщество, что облегчает поиск помощи и ресурсов для обучения и решения проблем.

- Открытый исходный код: Будучи инструментом для веб-скрейпинга с открытым исходным кодом, Selenium можно использовать бесплатно. Он позволяет пользователям расширять и изменять исходный код в соответствии с их потребностями.

Плюсы

- Открытый исходный код;

- Кроссбраузерная совместимость;

- Поддержка нескольких языков.

Минусы

- Сложность;

- Ограниченная поддержка динамических веб-страниц;

- Отсутствие встроенной отчетности.

Рейтинг

8. Dexi.io

Цены

- Пробный период: бесплатно. Протестируйте самый мощный инструмент для извлечения данных из веба на планете Земля.

- Стандарт: Создавайте сложные проекты данных с увеличенной вместимостью и поддержкой по электронной почте.

- Корпоративный: Расширяйте свои возможности с более высокими объемами, менеджером аккаунта и возможностями для расширения.

- Корпоративный уровень: Создавайте мощные решения для сбора данных, которые определяют стратегию веб-данных в больших масштабах.

Свяжитесь с их отделом продаж или службой поддержки клиентов. Они должны предоставить вам актуальные данные о ценах и о любых доступных пакетах или планах, которые могут соответствовать вашим специфическим потребностям.

Лучшие возможности

- Надежное извлечение данных: Dexi.io может извлекать данные с любых типов сайтов, включая те, которые имеют сложную структуру или используют JavaScript, AJAX, куки, сессии и перенаправления.

- Потоки данных и конвейеры: С помощью инструмента для веб-скрейпинга можно создать потоки данных, которые позволяют в едином процессе извлечь, преобразовать и загрузить (ETL) данные. Это удобно для очистки и форматирования данных во время их извлечения.

- Несколько типов извлечения: Поддерживает различные типы извлечения, такие как веб-обход для крупномасштабного извлечения данных, извлечение данных для точного и целенаправленного извлечения данных и загрузка файлов для скачивания файлов и изображений с сайтов.

- Инструмент на базе браузера: Это инструмент на базе браузера, что означает, что вам не нужно устанавливать программное обеспечение на ваш компьютер. Вы можете получить к нему доступ с любого устройства с подключением к интернету.

Плюсы

- Планирование и автоматизация;

- Несколько типов извлечения;

- Опции интеграции и экспорта.

Минусы

- Стоимость;

- Кривая обучения;

- Зависимость от интернет-соединения.

Рейтинг

9. Mozenda

Цены

- Пробный: бесплатно. Испытайте самый мощный инструмент для извлечения веб-данных на планете Земля.

- Стандарт: Создавайте сложные проекты данных с увеличенной производительностью и поддержкой по электронной почте.

- Корпоративный: Расширьте свои возможности с помощью увеличенного объёма, персонального менеджера и возможности расширения.

- Предприятие: Создавайте мощные решения для извлечения данных, которые управляют стратегией веб-данных в масштабе.

Основные функции

- Автоматическое извлечение данных: Позволяет планировать и автоматизировать процесс извлечения данных, экономя время и усилия. Вы можете настроить регулярные задачи по скрейпингу для выполнения в указанные интервалы.

- Трансформация и обогащение данных: Инструмент веб-скрейпинга предоставляет возможности для трансформации и обогащения извлеченных данных. Вы можете очищать и форматировать данные, выполнять расчеты, объединять наборы данных и добавлять пользовательские поля или значения.

- Опции интеграции и экспорта: Предлагает возможности интеграции с другими системами и сервисами. Можно экспортировать полученные данные в различных форматах, включая CSV, Excel, XML и JSON. Также поддерживается прямая интеграция с базами данных и API.

- Масштабируемость и производительность: Разработан для работы с крупномасштабными задачами скрейпинга. Этот инструмент обеспечивает масштабируемость и оптимизацию производительности для эффективного извлечения данных из многочисленных источников.

Плюсы

- Автоматизация и планирование;

- Опции интеграции и экспорта;

- Выделенная поддержка.

Минусы

- Цены;

- Кривая обучения;

- Ограниченная обработка JavaScript.

Оценка

10. Apify

Цены

- Бесплатный план: Инструмент для веб-скрейпинга предоставляет бесплатный план, включающий ограниченное количество вычислительных единиц (использование ЦПУ и памяти), бесплатное хранилище и ограниченный доступ к функциям. Этот план подходит для небольших задач скрейпинга или ознакомления с платформой.

- Старт: 49 долларов в месяц.

- Масштаб: 499 долларов в месяц.

- Бизнес: 999 долларов в месяц.

- Предприятие: на заказ.

Основные функции

- Интеграция и расширяемость: Программное обеспечение для веб-скрейпинга интегрируется с различными сторонними сервисами и платформами, что упрощает подключение задач к другим инструментам и системам. Оно предоставляет доступ к API и поддерживает интеграцию с такими сервисами, как Zapier, Google Sheets, Slack и другими.

- Мониторинг и оповещения: Обеспечивает функции мониторинга для отслеживания статуса и здоровья ваших задач и акторов скрейпинга. Вы можете настроить оповещения и уведомления, чтобы быть в курсе любых проблем или изменений в автоматизированных рабочих процессах.

- Сообщество и маркетплейс: Имеет активное сообщество и маркетплейс, где вы можете найти готовых акторов и делиться своими решениями, что позволяет использовать существующие решения и сотрудничать с другими пользователями.

Плюсы

- Автоматизация рабочих процессов;

- Интеграция и расширяемость;

- Активное сообщество и маркетплейс;

Минусы

- Крутая кривая обучения;

- Цены;

- Ограниченный контроль над инфраструктурой;

Рейтинг

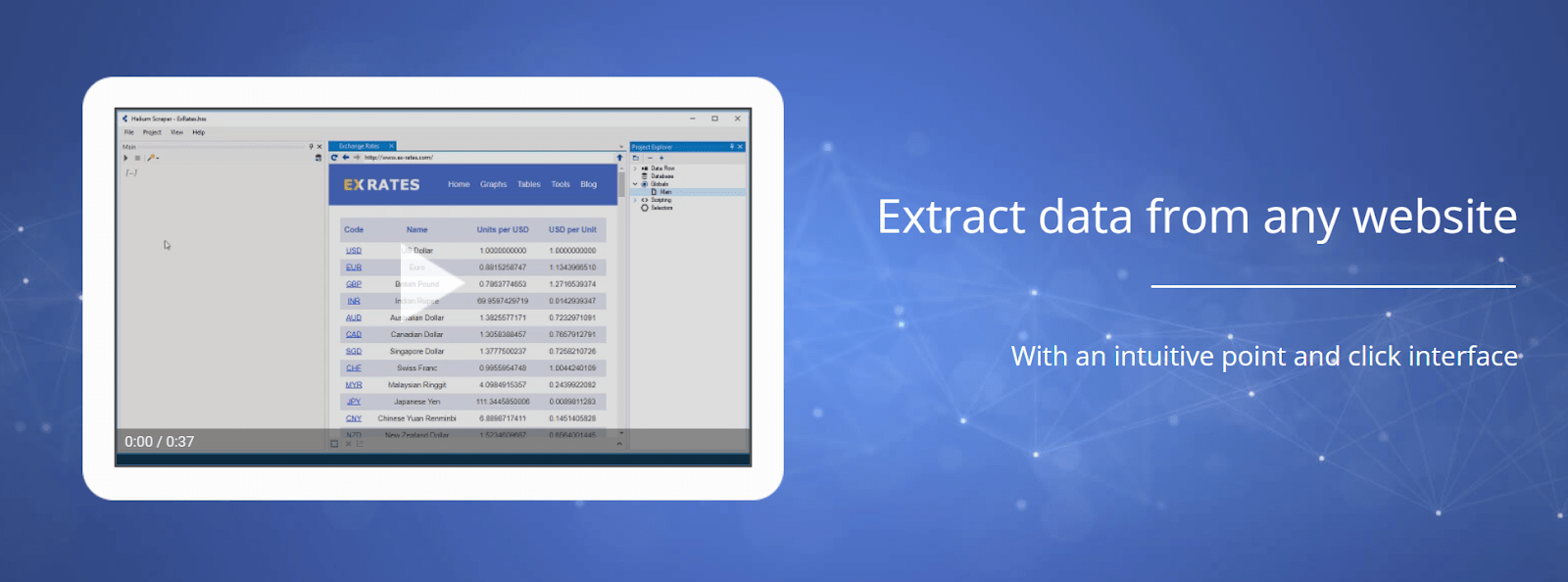

11. Helium Scraper

Цены

- Helium Scraper Basic: Базовая версия Helium Scraper доступна за единовременную оплату в размере $99. Эта версия предоставляет базовые функции для скрапинга и подходит для задач на меньшем масштабе.

- Helium Scraper Premium: Премиум версия доступна за единовременную оплату в размере $499. Она включает дополнительные расширенные функции и подходит для более сложных нужд скрапинга и проектов большего масштаба.

Основные функции

- Интерфейс "укажи и нажми": Инструмент для веб-скрапинга предлагает удобный интерфейс "укажи и нажми", который позволяет пользователям легко выбирать и извлекать элементы данных с веб-страниц без написания кода.

- Расширенные возможности скрапинга: Поддерживает скрапинг с веб-сайтов, использующих JavaScript, страниц с интенсивным использованием AJAX и динамическим контентом. Он способен справляться с комплексными сценариями скрапинга, включая вложенные структуры данных и пагинацию.

- Регулярные выражения и пользовательские функции: Позволяет пользователям применять регулярные выражения и пользовательские функции для извлечения и манипулирования данными. Это обеспечивает более сложные задачи по извлечению и преобразованию данных.

- Имітация работы веб-браузера: Программное обеспечение для веб-скрапинга симулирует среду веб-браузера, позволяя пользователям взаимодействовать с веб-сайтами во время процесса скрапинга. Это включает в себя обработку JavaScript, отправку форм и выполнение действий пользователя.

Плюсы

- Манипуляция данными;

- Имітация работы веб-браузера;

- Запланированный скрапинг и автоматизация.

Минусы

- Ограниченная совместимость с операционными системами;

- Отсутствие сообщества и поддержки;

- Цены.

Рейтинг

12. Diffbot

Цены

- Startup: $299 в месяц.

- Plus: $899 в месяц.

- Enterprise: индивидуально.

Основные функции

- Обработка естественного языка (NLP): Инструмент для веб-скрапинга анализирует и понимает извлекаемый контент, применяя техники NLP для извлечения значимой информации из текста. Это позволяет продвинутую обработку данных и анализ.

- Обогащение данных: Может обогащать извлеченные данные, автоматически добавляя контекстуально релевантную информацию из внешних источников. Это может включать профили в социальных сетях, информацию о компании, связанные статьи и многое другое.

- Автоматическое структурирование данных: Программное обеспечение для веб-скрейпинга организует извлеченные данные в структурированные форматы, такие как JSON или CSV, что упрощает работу с ними и интеграцию в другие системы и инструменты.

- Обучение ИИ: Оно позволяет пользователям обучать модели машинного обучения на заказ для определенных веб-сайтов или доменов. Это позволяет извлекать данные из сложных или уникальных веб-страниц, которые могут требовать индивидуальных настроек.

- Извлечение URL, HTML и PDF: Поддерживает извлечение данных не только из веб-страниц, но и из URL, HTML-кода и PDF-документов. Это расширяет его функциональность на более широкий диапазон источников данных.

Плюсы

- Обработка естественного языка (NLP);

- Выход структурированных данных;

- Масштабируемость и производительность.

Минусы

- Ограниченная настройка;

- Зависимость от алгоритмов ИИ;

- Ценообразование.

Рейтинг

13. WebSundew

Ценообразование

- Lite: $99 в месяц.

- Standard: $399 в месяц.

- Professional: $899 в месяц.

- Enterprise: $2499 в месяц.

Основные функции

- Автоматизированное извлечение данных: WebSundew поддерживает планирование и автоматизацию задач скрейпинга, позволяя пользователям настраивать повторяющиеся задания на скрейпинг через определенные интервалы. Это обеспечивает автоматизированное извлечение данных и регулярные обновления.

- Встроенный редактор рабочих процессов: включает в себя редактор рабочих процессов, позволяющий пользователям создавать, изменять и управлять рабочими процессами скрейпинга. Инструмент предоставляет функции такие как предварительный просмотр данных, обработка ошибок и условная логика.

- Экспорт и интеграция данных: позволяет пользователям экспортировать собранные данные в различных форматах, включая CSV, Excel, XML и базы данных. Этот инструмент также поддерживает прямую интеграцию с внешними системами и API для бесшовной передачи данных.

- Использование прокси и ротация IP: Инструмент веб-скрейпинга поддерживает использование прокси, что позволяет пользователям менять IP-адреса и обходить ограничения или лимиты, установленные веб-сайтами. Это помогает сохранять анонимность и избегать блокировки IP.

Плюсы

- Извлечение и трансформация данных;

- Экспорт и интеграция данных;

- Использование прокси и ротация IP.

Минусы

- Ограниченная настройка;

- Кривая обучения.

Рейтинг

14. ScraperAPI

Цены

- Бесплатный план: Предлагает начальное количество бесплатных API кредитов (например, 5000) для тестирования и небольших проектов.

- План "Хобби": $49 в месяц, подходит для разработчиков и нужд малого масштабирования.

- План "Стартап": $149 в месяц, предлагает более высокие лимиты вызовов API и параллельные запросы для растущих приложений.

- Бизнес-план: От $299 в месяц, разработан для значительных объемов извлечения данных с премиум функциями.

- Корпоративный план: Индивидуальное ценообразование для крупномасштабных операций, требующих индивидуальных решений, высокой параллельности и выделенной поддержки.

Основные функции

- Автоматическое управление прокси: Автоматически обрабатывает ротацию прокси, используя пул из миллионов IP-адресов (включая датацентры и жилые варианты) в десятках стран, практически исключая блокировки IP.

- Рендеринг JavaScript: Способен обрабатывать сайты с тяжелым использованием JavaScript и одностраничные приложения (SPA), обеспечивая доступ к динамически загружаемому контенту.

- Обработка CAPTCHA: Включает системы для автоматического решения CAPTCHA, возникающих в процессе скрапинга.

- Простые API-эндпоинты: Функционирует как простой API для веб-скрапинга; пользователи просто передают целевой URL и получают сырой HTML-ответ, абстрагируя сложности.

- Геотаргетинг: Позволяет указать страну для выходного узла прокси, что важно для доступа к регионально специфическим данным или ценам.

Плюсы

- Упрощенная инфраструктура

- Высокий процент успешных операций

- Легкая интеграция API

- Масштабируемость

Минусы

- Потенциальные затраты при масштабировании

- Ориентация на API (нет графического интерфейса)

Рейтинг

Сбор данных как мощный инструмент

Вот общее представление о том, как работает сбор данных с веб-страниц:

- Получение веб-контента: Процесс сбора данных начинается с отправки HTTP-запросов на сервер целевого веб-сайта для получения HTML-контента определенной веб-страницы. Это можно сделать с помощью языков программирования, таких как Python, или специализированных инструментов для сбора данных.

- Разбор HTML: После получения HTML-контента следующим шагом является извлечение из него релевантных данных. Это включает разбор HTML-документа для идентификации и поиска конкретных элементов, таких как заголовки, абзацы, таблицы или ссылки.

- Извлечение данных: После идентификации нужных элементов сбор данных извлекает необходимые данные с использованием таких техник, как XPath, CSS-селекторы, регулярные выражения или специализированные библиотеки, такие как Beautiful Soup на Python. Извлеченные данные могут включать текст, изображения, ссылки или любой другой контент на веб-странице.

- Хранение и обработка данных: Извлеченные данные могут быть сохранены в различных форматах, таких как CSV, JSON или база данных. После сохранения данные могут быть обработаны, проанализированы или интегрированы в другие системы или приложения для дальнейшего использования.

Инструменты для сбора данных с веб-страниц следует использовать ответственно и в соответствии с условиями использования сайта и юридическими ограничениями.

Часто задаваемые вопросы об инструментах для сбора данных с веб-страниц

1. Что такое инструменты для сбора данных с веб-страниц?

Инструмент для сбора данных с веб-страниц — это программное обеспечение или библиотека, которые автоматизируют процесс сбора данных. Эти инструменты предлагают функциональность для более удобного и эффективного получения, разбора и извлечения данных с сайтов. Они часто включают функции, такие как извлечение данных, преобразование данных, планирование, управление прокси и др.

2. Являются ли инструменты для сбора данных с веб-страниц законными?

Законность веб-скрейпинга зависит от различных факторов, включая условия использования сайта, юрисдикцию и цель скрейпинга. Как правило, скрейпинг общественных данных с сайтов без нанесения вреда или нарушения каких-либо законов считается допустимым. Однако скрейпинг частной или защищенной авторским правом информации, чувствительных личных данных или обход мер безопасности обычно запрещен. Важно ознакомиться с условиями использования и применимыми законами перед тем, как заниматься скрейпингом любого сайта.

4. Могут ли инструменты для веб-скрейпинга обрабатывать сайты, рендеренные на JavaScript?

Некоторые инструменты для веб-скрейпинга могут обрабатывать сайты, рендеренные на JavaScript, в то время как другим могут потребоваться дополнительные настройки или инструменты. Такие инструменты, как Selenium, которые автоматизируют взаимодействие с браузером, часто используются для скрейпинга сайтов, которые значительно зависят от JavaScript для загрузки динамического контента. Кроме того, некоторые библиотеки или фреймворки, такие как Puppeteer (для Node.js) или Splash, предоставляют возможности рендеринга JavaScript, специально разработанные для целей веб-скрейпинга.

5. Есть ли какие-либо ограничения или сложности с инструментами для веб-скрейпинга?

Инструменты для веб-скрейпинга могут сталкиваться с ограничениями или сложностями в зависимости от сложности целевого сайта или объема данных, которые нужно скрейпить. Некоторые из распространенных трудностей включают в себя динамические сайты, защиту CAPTCHA, блокировку IP, ограничения по скорости или изменения в структуре сайта. Продвинутые техники, такие как вращение прокси-серверов, подмена пользователя, или внедрение механизмов задержки могут помочь смягчить эти трудности.