14 beste Web-Scraping-Tools für die Datenerfassung im Jahr 2026

Web Scraping kann für verschiedene Zwecke nützlich sein, wie zum Beispiel Marktforschung, Datenanalyse, Inhaltsaggregation, Preisvergleiche, Überwachung von Websites auf Änderungen und viele andere. Betrachten wir die 14 besten Web-Scraping-Tools zur Datenerfassung im Jahr 2026.

Inhaltsverzeichnis

Was ist Web Scraping?

Web Scraping ist eine Technik zur automatischen Extraktion von Daten aus Websites. Dabei wird ein Programm geschrieben oder ein Tool verwendet, um auf Webseiten zuzugreifen und Informationen abzurufen, typischerweise in einem strukturierten Format wie HTML oder XML. Web-Scraping-Tools ermöglichen es den Benutzern, große Mengen an Daten von mehreren Websites zu sammeln, die dann analysiert, verarbeitet oder für verschiedene Zwecke verwendet werden können.

14 Beste Web Scraping Tools

|

Web Scraping Tools |

Startpreis |

JavaScript Unterstützung |

IP Rotation |

|

75 $ pro Monat |

✔️ |

✔️ |

|

|

Kostenlos |

✔️ |

X |

|

|

189 $ pro Monat |

✔️ |

✔️ |

|

|

199 $ pro Monat |

✔️ |

✔️ |

|

|

50 $ pro Monat |

X |

✔️ |

|

|

Kostenlos |

X |

✔️ |

|

|

Kostenlos |

✔️ |

✔️ |

|

|

Individuell |

✔️ |

✔️ |

|

|

Individuell |

X |

✔️ |

|

|

49 $ pro Monat |

✔️ |

✔️ |

|

|

99 $ pro Monat |

✔️ |

✔️ |

|

|

299 $ pro Monat |

✔️ |

✔️ |

|

|

99 $ pro Monat |

✔️ |

✔️ |

|

| Kostenlos/$49 |

✔️ |

✔️ |

1. Octoparse

Preise

- Kostenloser Plan: Bietet eingeschränkte Funktionen und ermöglicht 10 Crawler.

- Standardplan: Kostet etwa 75 $ pro Monat. Dieses Paket ermöglicht unbegrenzte Crawler, IP-Drehungen und API-Zugriff.

- Professioneller Plan: Kostet etwa 209 $ pro Monat. Dieses Paket ist für die großflächige Datenextraktion und beinhaltet alle Funktionen des Standardplans sowie eine Prioritätswarteschlange, Hochgeschwindigkeitsextraktion und mehr.

Top-Features

- Datenexport: Octoparse unterstützt den Export von gescrapten Daten in verschiedenen Formaten wie CSV, Excel, HTML, TXT und Datenbanken (MySQL, SQL Server und Oracle).

- Erweitertes Reguläres-Ausdruck-Tool: Dieses Tool hilft bei komplexeren Datenscraping-Situationen.

- Web-Scraping-Vorlagen: Octoparse bietet vorformatierte Vorlagen zum Scrapen von Daten von bestimmten Websites wie Amazon, eBay, Twitter usw.

- Captcha-Lösung: Es kann einige Arten von CAPTCHA während des Scraping-Prozesses automatisch lösen.

Vorteile

- IP-Rotation;

- Erweiterte Datenextraktion;

- Geplante Extraktion;

- Umfangreiche Exportoptionen.

Nachteile

- Einschränkungen bei dynamischen Websites;

- Geschwindigkeit;

- Begrenzte Captcha-Lösung.

Bewertung

2. Scrapy

Preisgestaltung

Scrapy ist ein Open-Source-Framework, das für das Web-Scraping in Python verwendet wird. Als Open-Source-Web-Scraping-Tool ist es kostenlos für jeden, der es herunterladen und verwenden möchte.

Top-Features

- Eingebautes Follow-Links: Scrapy kann Links automatisch basierend auf den festgelegten Regeln folgen, was bei der Navigation für die Datenextraktion hilft.

- Befehlszeilentool: Es bietet ein Befehlszeilentool, um den Scraping-Prozess zu steuern. Das Tool bietet Befehle zum Erstellen neuer Projekte, Spider, Parsen von URLs usw.

- Robuste Datenverarbeitungspipelines: Es bietet leistungsstarke Möglichkeiten zum Bereinigen und Validieren der gescrapten Daten mit seinen Pipelines.

- Eingebaute HTTP-Funktionen: Das Scraping-Tool unterstützt Funktionen wie Authentifizierung, das Handling von Cookies, das Wiederholen fehlgeschlagener Anfragen und andere.

- Datenexport: Es bietet integrierte Unterstützung für die Ausgabe der gescrapten Daten in verschiedenen Formaten wie JSON, XML und CSV.

Vorteile

- Erweiterbarkeit;

- Community und Support;

- Datenexport.

Nachteile

- Weniger intuitiv für Single-Page-Anwendungen;

- Keine GUI;

- Erfordert Einrichtung und Wartung.

Bewertung

3. ParseHub

Preisgestaltung

- Kostenloser Plan: Der kostenlose Plan von ParseHub bietet eingeschränkte Funktionen und erlaubt 200 Seiten pro Lauf sowie 5 öffentliche Projekte.

- Standard Plan: Dieser Plan kostet ungefähr 189 USD pro Monat und erlaubt bis zu 10.000 Seiten pro Lauf und 20 private Projekte.

- Professional Plan: Dieser Plan kostet etwa 599 USD pro Monat und bietet unbegrenzte Seiten pro Lauf und 120 private Projekte.

- Enterprise Plan: Für größere Unternehmen oder spezielle Anforderungen bietet das Web-Scraping-Tool einen Enterprise-Plan, der umfangreichere Datenextraktionsmöglichkeiten, exzellenten Support und maßgeschneiderte Lösungen bietet. Der Preis für diesen Plan wurde nicht angegeben und ist wahrscheinlich verhandelbar, basierend auf den speziellen Bedürfnissen des Nutzers.

Top-Features

- Datenexport: Es unterstützt den Export von gescrapten Daten in mehreren Formaten, einschließlich CSV, Excel und JSON oder über ihre API.

- API-Zugang: Es bietet eine API, die Sie nutzen können, um Ihre Projekte programmatisch zu verwalten und auszuführen.

- Mehrseitiges Crawling: Mit der Web-Scraping-Software können Sie Regeln festlegen, um Links zu folgen und durch mehrere Seiten zu crawlen, um vollständige Datenextraktion zu gewährleisten.

- Bedingte Logik: ParseHub ermöglicht es Ihnen, in Ihrer Scraping-Konfiguration bedingte Logik zu implementieren, um verschiedene Scraping-Szenarien zu handhaben.

- Cloud-basiert: Es ist ein cloud-basiertes Tool, was bedeutet, dass Sie Ihre Projekte laufen lassen können und dann Ihren Computer schließen können, ohne den Datenextraktionsprozess zu unterbrechen.

Vorteile

- Geplante Läufe;

- Cloud-basiert;

- Erweiterte Selektoren.

Nachteile

- API-Zugang;

- Geschwindigkeit;

- Begrenzter kostenloser Plan.

Bewertung

4. Import.io

Preisgestaltung

- Starter-Paket: Entwickelt für kleine Unternehmen und Einzelbenutzer mit grundlegenden Web-Scraping-Anforderungen.

- Standard-Paket: Entwickelt, um Informationen von interaktiven Websites zu abrufen und CAPTCHAs sowie Zugangshindernisse zu überwinden.

- Paket für Fortgeschrittene: Entwickelt, um effizient große Datenmengen zu extrahieren und die höchste Priorität für Anwendungsfälle mit umfassender Unterstützung zu bedienen.

- Individuell: Ausgerichtet auf große Konzerne mit hohem Datenextraktionsbedarf und Anforderungen an erweiterte Funktionen sowie bevorzugtem Support.

Top-Features

- Datenqualitätsgarantie: Es bietet Funktionen zur Sicherstellung der Datenqualität, die gewährleisten, dass die extrahierten Daten genau und vollständig sind.

- Planung und Automatisierung: Die Web-Scraping-Software ermöglicht es Ihnen, Ihre Scraping-Aufgaben zu planen, sodass sie in bestimmten Intervallen ausgeführt werden, was nützlich für Projekte ist, bei denen regelmäßige Datenaktualisierungen benötigt werden.

- API-Zugang: Sie stellt eine API bereit, die Sie zur Verwaltung und Ausführung Ihrer Projekte programmatisch nutzen können oder um die extrahierten Daten direkt in Ihre Anwendungen zu integrieren.

- Webhooks: Webhooks ermöglichen die Echtzeit-Datenlieferung, was bedeutet, dass Ihre Daten an Ihren Endpunkt gesendet werden, sobald sie fertig sind.

Vorteile

- Planung und Automatisierung;

- API-Zugang;

- Cloud-basiert.

Nachteile

- Preisgestaltung;

- Lernkurve;

- Kundensupport.

Bewertung

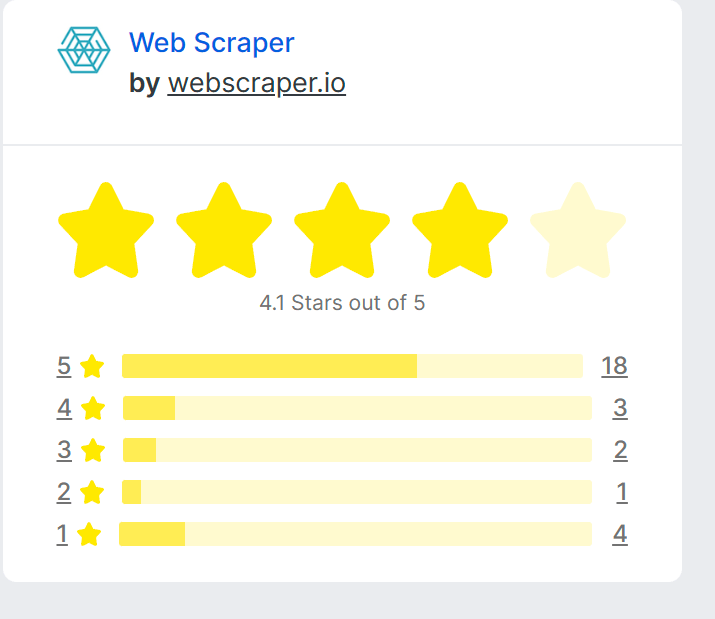

5. Web Scraper

Preisgestaltung

- Web Scraper Browser-Erweiterung: Dies ist ein kostenloses Tool, das als Browser-Erweiterung für Chrome verfügbar ist. Es ermöglicht Ihnen, kleine bis mittlere Scraping-Aufgaben in Ihrem Browser einzurichten und auszuführen.

- Projekt: 50 $ pro Monat.

- Professionell: 100 $ pro Monat.

- Business: 200 $ pro Monat.

- Scale: ab 300 $ pro Monat.

Top-Features

- Multi-Page-Scraping: Web Scraper kann mehrere Seiten einer Website navigieren, um Daten zu extrahieren, und kann auch Websites handhaben, die unendliches Scrollen verwenden.

- Sitemap-basierte Struktur: Ein Web-Scraping-Tool strukturiert Ihr Scraping-Projekt als Sitemap, in der Sie definieren können, welche Seiten zu navigieren sind, welche Daten extrahiert werden sollen und wie die Seiten miteinander verbunden sind.

- Datenexport: Web Scraper unterstützt den Export der extrahierten Daten in verschiedenen Formaten, einschließlich CSV.

- Cloud-basiertes Scraping: Mit dem Cloud-Service (eine kostenpflichtige Funktion) können Sie Ihre Scraping-Aufgaben skalieren und auf den Servern von Web Scraper ausführen lassen, sodass Sie Ihre eigenen Computerressourcen sparen.

Vorteile

- Unterstützung für Multi-Page und unendliches Scrollen;

- Cloud-basiertes Scraping;

- Datenexport.

Nachteile

- Eingeschränkte Funktionen in der kostenlosen Version;

- Keine JavaScript-Darstellung in der kostenlosen Version;

- Lernkurve.

Bewertung

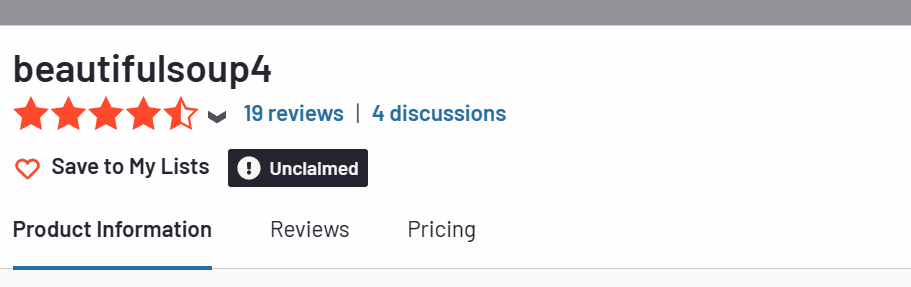

6. Beautiful Soup

Preisgestaltung

Beautiful Soup ist eine Open-Source-Bibliothek für Python, die zum Web-Scraping verwendet wird, um Daten aus HTML- und XML-Dateien zu extrahieren. Sie ist frei verfügbar für die Nutzung und Modifikation. Es entstehen keine Kosten für die Nutzung von Beautiful Soup.

Wie bei jedem Open-Source-Tool können allerdings je nach Verwendung der Bibliothek Kosten anfallen. Beispielsweise könnten Sie Zeit investieren müssen, um zu lernen, wie man die Bibliothek verwendet, oder Sie könnten für Rechenressourcen bezahlen müssen, wenn Sie großflächige Datenextraktionen durchführen.

Top-Features

- Einfache Navigation: Das Web-Scraping-Tool verwandelt ein komplexes HTML-Dokument in einen Baum aus Python-Objekten, wie Tags, navigierbare Strings oder Kommentare. Sie können in diesem Baum navigieren und die benötigten Daten finden.

- Suchfunktionen im Parse-Baum: Beautiful Soup bietet Methoden und Pythonische Idiome für die Suche im Parse-Baum. Sie können Elemente nach ihren Tags, Attributen, Textinhalt oder ihrer Beziehung zu anderen Elementen filtern.

- Modifikation des Parse-Baums: Die Web-Scraping-Software ermöglicht Ihnen die Modifikation des Parse-Baums oder einzelner Elemente darin. Das bedeutet, dass Sie Tag-Namen und Attributwerte ändern, neue Tags hinzufügen, .string und .contents modifizieren, replace_with() und insert() verwenden können und mehr.

- Ausgabe des Parse-Baums: Sie bietet Methoden für das ansprechende Ausdrucken des Parse-Baums mit oder ohne Formatierung.

- Parse-Filter: Sie unterstützt komplexe Muster und Methoden für die Suche im Parse-Baum. Sie können eine Funktion, einen regulären Ausdruck, eine Liste oder einen String zur Filterung während einer Suche verwenden.

Vorteile

- Open Source;

- Gut dokumentiert;

- Community.

Nachteile

- Erfordert Programmierkenntnisse;

- Geschwindigkeit;

- Keine JavaScript-Unterstützung.

Bewertung

7. Selenium

Preisgestaltung

Selenium ist ein kostenloses und Open-Source-Framework für automatisiertes Testen, das zur Validierung von Webanwendungen in verschiedenen Browsern und Plattformen verwendet wird. Es ist kostenlos nutzbar, aber dank seines Open-Source-Charakters können Sie auch den Quellcode ändern, um Ihre Anforderungen zu erfüllen.

Dies vorausgesetzt, können mit der Nutzung von Selenium dennoch indirekte Kosten verbunden sein:

- Lern- und Entwicklungszeit.

- Infrastrukturkosten.

- Supportkosten.

Top-Features

- Selenium Grid: Die Web-Scraping-Software ermöglicht das parallele Ausführen von Tests, bei denen verschiedene Tests gleichzeitig auf unterschiedlichen Remote-Maschinen ausgeführt werden können. Dies hilft, die Zeit zur Ausführung parallelisierter Tests zu verkürzen und ermöglicht schnellere Rückmeldungen.

- Integration mit anderen Tools: Es kann leicht mit Tools wie TestNG und JUnit zur Verwaltung von Testfällen und Generierung von Berichten integriert werden. Dieses Tool kann auch mit Maven, Jenkins und Docker für kontinuierliches Testen integriert werden.

-

Community Support: Es hat eine große Benutzerbasis und eine aktive Community, was es einfacher macht, Hilfe und Ressourcen für das Lernen und Problemlösen zu finden.

- Open Source: Als ein Open-Source-Web-Scraping-Tool ist Selenium kostenlos nutzbar und erlaubt es den Nutzern, den Quellcode zu erweitern und anzupassen, um ihren Bedürfnissen gerecht zu werden.

Vorteile

- Open Source;

- Kompatibilität mit verschiedenen Browsern;

- Unterstützung für mehrere Sprachen.

Nachteile

- Komplexität;

- Eingeschränkte Unterstützung für dynamische Webseiten;

- Kein integriertes Reporting.

Bewertung

8. Dexi.io

Preise

- Testversion: kostenlos. Testen Sie das leistungsfähigste Web-Datenextraktionstool der Erde.

- Standard: Erstellen Sie komplexe Datenprojekte mit erhöhtem Kapazitäts- und E-Mail-Support.

- Corporate: Erweitern Sie Ihre Reichweite mit höherem Volumen, einem Account Manager und Erweiterungsoptionen.

- Enterprise: Erstellen Sie leistungsstarke Erntelösungen, die die Web-Datenstrategie im großen Maßstab fördern.

Kontaktieren Sie deren Verkaufs- oder Kundenservice-Team. Diese sollten Ihnen die aktuellen Preisdaten und verfügbare Pakete oder Pläne bereitstellen können, die Ihren spezifischen Anforderungen entsprechen.

Wichtigste Funktionen

- Robuste Datenextraktion: Dexi.io kann Daten von allen Arten von Webseiten extrahieren, einschließlich solcher mit komplexen Strukturen oder solchen, die JavaScript, AJAX, Cookies, Sitzungen und Weiterleitungen verwenden.

- Datenfluss und Pipelines: Mit einem Web-Scraping-Tool können Sie Datenflusspipelines erstellen, die es Ihnen ermöglichen, Daten in einem einzigen Prozess zu extrahieren, zu transformieren und zu laden (ETL). Dies ist nützlich, um die Daten während der Extraktion zu bereinigen und zu formatieren.

- Verschiedene Extraktionstypen: Es unterstützt verschiedene Arten der Extraktion, wie Web-Crawling für großangelegte Datenextraktionen, Datenextraktion für präzise und gezielte Datenextraktionen sowie Dateidownloads zum Herunterladen von Dateien und Bildern von Webseiten.

- Browserbasiertes Tool: Es handelt sich um ein browserbasiertes Tool, was bedeutet, dass Sie keine Software auf Ihrem Rechner installieren müssen. Sie können es von jedem Gerät mit Internetverbindung aus zugreifen.

Vorteile

- Planung und Automatisierung;

- Verschiedene Extraktionstypen;

- Integrations- und Exportoptionen.

Nachteile

- Preisgestaltung;

- Lernkurve;

- Abhängigkeit von Internetverbindung.

Bewertung

9. Mozenda

Preisgestaltung

- Testversion: kostenlos. Probieren Sie das leistungsstärkste Web-Datenextraktionstool der Welt aus.

- Standard: Erstellen Sie komplexe Datenprojekte mit erhöhter Kapazität und E-Mail-Support.

- Corporate: Erweitern Sie Ihre Reichweite mit höherem Volumen, einem Account-Manager und Erweiterungsmöglichkeiten.

- Enterprise: Erstellen Sie leistungsstarke Erntelösungen, die die Web-Datenstrategie im großen Maßstab vorantreiben.

Top-Funktionen

- Automatisierte Datenextraktion: Ermöglicht die Planung und Automatisierung des Datenextraktionsprozesses, wodurch Zeit und Mühe gespart werden. Sie können wiederkehrende Scraping-Aufgaben einrichten, um in festgelegten Intervallen ausgeführt zu werden.

- Datenumwandlung und -anreicherung: Das Web-Scraping-Tool bietet Funktionen zur Transformation und Anreicherung der extrahierten Daten. Sie können die Daten bereinigen und formatieren, Berechnungen durchführen, Datensets zusammenführen und benutzerdefinierte Felder oder Werte hinzufügen.

- Integrations- und Exportoptionen: Es bietet Integrationsmöglichkeiten mit anderen Systemen und Diensten. Sie können die gescrapten Daten in verschiedenen Formaten exportieren, darunter CSV, Excel, XML und JSON. Es unterstützt auch die direkte Integration mit Datenbanken und APIs.

- Skalierbarkeit und Leistung: Es ist für die Bewältigung großer Scraping-Aufgaben ausgelegt. Dieses Tool bietet Funktionen zur Skalierbarkeit und Leistungsoptimierung, um eine effiziente Datenextraktion aus zahlreichen Quellen sicherzustellen.

Vorteile

- Automatisierung und Planung;

- Integrations- und Exportoptionen;

- Engagierter Support.

Nachteile

- Preisgestaltung;

- Lernkurve;

- Eingeschränkte JavaScript-Handhabung.

Bewertung

10. Apify

Preisgestaltung

- Gratis-Plan: Das Web-Scraping-Tool bietet einen Gratis-Plan, der eine begrenzte Anzahl kostenloser Recheneinheiten (CPU- und Speicherverbrauch), kostenlosen Speicherplatz und eingeschränkten Zugang zu Funktionen beinhaltet. Dieser Plan eignet sich für kleine Scraping-Aufgaben oder um die Plattform auszuprobieren.

- Starter: 49 € pro Monat.

- Scale: 499 € pro Monat.

- Business: 999 € pro Monat.

- Enterprise: individuell.

Top-Funktionen

- Integration und Erweiterbarkeit: Die Web-Scraping-Software integriert sich mit verschiedenen Drittanbieterdiensten und Plattformen, sodass Sie Ihre Scraping-Aufgaben einfach mit anderen Tools und Systemen verbinden können. Sie bietet API-Zugriff und unterstützt die Integration mit Diensten wie Zapier, Google Sheets, Slack und mehr.

- Überwachung und Alarmierung: Sie bietet Überwachungsfunktionen zur Verfolgung des Status und der Gesundheit Ihrer Scraping-Aufgaben und Akteure. Sie können Alarme und Benachrichtigungen einrichten, um über Probleme oder Änderungen in Ihren automatisierten Workflows informiert zu bleiben.

- Community und Marktplatz: Sie hat eine aktive Community und einen Marktplatz, auf dem Sie vorgefertigte Akteure finden und eigene teilen können, sodass Sie bestehende Lösungen nutzen und mit anderen Benutzern zusammenarbeiten können.

Vorteile

- Workflow-Automatisierung;

- Integration und Erweiterbarkeit;

- Aktive Community und Marktplatz;

Nachteile

- Lernkurve;

- Preisgestaltung;

- Begrenzte Kontrolle über die Infrastruktur;

Bewertung

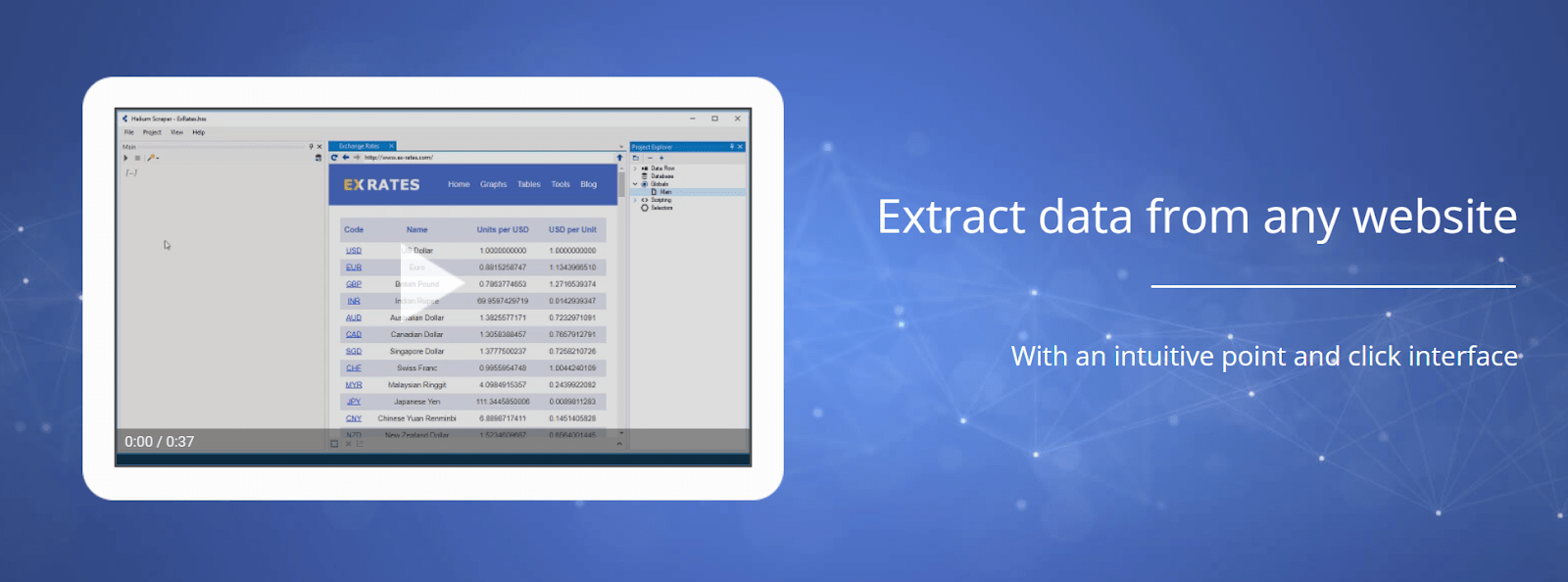

11. Helium Scraper

Preisgestaltung

- Helium Scraper Basic: Die Basic-Version von Helium Scraper ist für eine Einmalzahlung von 99 $ erhältlich. Diese Version bietet grundlegende Web-Scraping-Funktionen und eignet sich für kleinere Web-Scraping-Aufgaben im kleinen Maßstab.

- Helium Scraper Premium: Die Premium-Version ist für eine Einmalzahlung von 499 $ erhältlich. Sie beinhaltet zusätzliche erweiterte Funktionen und ist für komplexere Web-Scraping-Anforderungen und größere Projekte geeignet.

Top-Features

- Point-and-Click-Oberfläche: Das Web-Scraping-Tool bietet eine benutzerfreundliche Point-and-Click-Oberfläche, mit der Benutzer Datenlemente aus Webseiten einfach auswählen und extrahieren können, ohne Code schreiben zu müssen.

- Erweiterte Web-Scraping-Fähigkeiten: Es unterstützt das Scraping von JavaScript-gerenderten Websites, seiten mit hohem AJAX-Anteil und dynamischen Inhalten. Es kann komplexe Web-Scraping-Szenarien handhaben, einschließlich verschachtelter Datenstrukturen und Paginierung.

- Reguläre Ausdrücke und benutzerdefinierte Funktionen: Benutzer können reguläre Ausdrücke und benutzerdefinierte Funktionen anwenden, um Daten zu extrahieren und zu manipulieren. Dies ermöglicht fortgeschrittenere Datenextraktions- und Transformationsaufgaben.

- Web-Browser-Simulation: Die Web-Scraping-Software simuliert eine Webbrowser-Umgebung, wodurch Benutzer während des Web-Scraping-Prozesses mit Websites interagieren können. Dies umfasst das Handhaben von JavaScript, das Absenden von Formularen und das Ausführen von Benutzeraktionen.

Vorteile

- Datenmanipulation;

- Web-Browser-Simulation;

- Geplantes Web-Scraping und Automatisierung.

Nachteile

- Eingeschränkte Betriebssystemkompatibilität;

- Mangel an Gemeinschaft und Support;

- Preisgestaltung.

Bewertung

12. Diffbot

Preisgestaltung

- Startup: 299 $ pro Monat.

- Plus: 899 $ pro Monat.

- Enterprise: individuell.

Top-Features

- Natürliche Sprachverarbeitung (NLP): Das Web-Scraping-Tool analysiert und versteht den extrahierten Inhalt und wendet NLP-Techniken an, um sinnvolle Informationen aus Texten zu extrahieren. Dies ermöglicht fortschrittliche Datenverarbeitung und -analyse.

- Datenanreicherung: Es kann extrahierte Daten anreichern, indem automatisch kontextbezogene Informationen aus externen Quellen hinzugefügt werden. Diese können Social-Media-Profile, Unternehmensinformationen, verwandte Artikel und mehr umfassen.

- Automatische Strukturierung von Daten: Web-Scraping-Software organisiert extrahierte Daten in strukturierte Formate wie JSON oder CSV, was die Arbeit mit ihnen und die Integration in andere Systeme und Tools erleichtert.

- KI-Training: Sie ermöglicht es Benutzern, benutzerdefinierte maschinelle Lernmodelle für spezifische Websites oder Domains zu trainieren. Dies ermöglicht die Extraktion von Daten aus komplexen oder einzigartigen Webseiten, die möglicherweise kundenspezifische Konfigurationen erfordern.

- URL-, HTML- und PDF-Extraktion: Sie unterstützt die Extraktion von Daten nicht nur aus Webseiten, sondern auch aus URLs, HTML-Code und PDF-Dokumenten. Dies erweitert ihre Funktionalität auf eine breitere Palette von Datenquellen.

Vorteile

- Verarbeitung natürlicher Sprache (NLP);

- Strukturierte Datenausgabe;

- Skalierbarkeit und Leistung.

Nachteile

- Begrenzte Anpassungsmöglichkeiten;

- Abhängigkeit von KI-Algorithmen;

- Preisgestaltung.

Bewertung

13. WebSundew

Preisgestaltung

- Lite: $99 pro Monat.

- Standard: $399 pro Monat.

- Professional: $899 pro Monat.

- Enterprise: $2499 pro Monat.

Top-Funktionen

- Automatisierte Datenextraktion: WebSundew unterstützt die Planung und Automatisierung von Scraping-Aufgaben, sodass Benutzer wiederkehrende Scraping-Jobs in bestimmten Intervallen einrichten können. Dies ermöglicht eine freihändige Datenerfassung und regelmäßige Aktualisierungen.

- Eingebauter Workflow-Editor: Er beinhaltet einen Workflow-Editor, der es Benutzern ermöglicht, Scraping-Workflows zu erstellen, zu ändern und zu verwalten. Das Tool bietet Funktionen wie Datenvorschau, Fehlerbehandlung und bedingte Logik.

- Datenexport und Integration: Es ermöglicht Benutzern, extrahierte Daten in verschiedenen Formaten zu exportieren, darunter CSV, Excel, XML und Datenbanken. Dieses Tool unterstützt auch die direkte Integration mit externen Systemen und APIs für nahtlosen Datentransfer.

- Proxy- und IP-Rotation: Das Web-Scraping-Tool unterstützt die Nutzung von Proxys, sodass Benutzer IP-Adressen rotieren und Beschränkungen oder Begrenzungen überwinden können, die von Websites auferlegt werden. Dies hilft, Anonymität zu wahren und IP-Sperrungen zu vermeiden.

Vorteile

- Datenextraktion und -transformation;

- Datenexport und Integration;

- Proxy- und IP-Rotation.

Nachteile

- Begrenzte Anpassungsmöglichkeiten;

- Lernkurve.

Bewertung

14. ScraperAPI

Preise

- Free Plan: Bietet eine anfängliche Anzahl von kostenlosen API-Credits (z. B. 5,000) für Tests und kleine Projekte.

- Hobby Plan: 49 $ pro Monat, geeignet für Entwickler und kleine Scraping-Anforderungen.

- Startup Plan: 149 $ pro Monat, bietet höhere API-Aufruflimits und gleichzeitige Anfragen für wachsende Anwendungen.

- Business Plan: Ab 299 $ pro Monat, entwickelt für umfangreiche Datenextraktionsvolumen mit Premium-Funktionen.

- Enterprise Plan: Individuelle Preisgestaltung für groß angelegte Operationen, die maßgeschneiderte Lösungen, hohe Gleichzeitigkeit und dedizierten Support erfordern.

Top-Funktionen

- Automatisiertes Proxy-Management: Handhabt die Proxy-Rotation automatisch mit Hilfe eines Pools von Millionen IPs (einschließlich Rechenzentrums- und Wohnoptionen) über Dutzende von Ländern, was IP-Sperren praktisch eliminiert.

- JavaScript-Rendering: Kann JavaScript-lastige Websites und Single Page Applications (SPAs) rendern, um den Zugang zu dynamisch geladenen Inhalten sicherzustellen.

- CAPTCHA-Handhabung: Integriert Systeme zur automatischen Lösung von CAPTCHAs, die während Scraping-Versuchen auftreten.

- Einfaches API Endpoint: Funktioniert als unkomplizierte Web Scraping API; Benutzer geben einfach die Ziel-URL an und erhalten die rohe HTML-Antwort, wodurch Komplexitäten abstrahiert werden.

- Geotargeting: Ermöglicht die Spezifizierung des Landes für den Proxy-Austrittsknoten, essentiell für den Zugriff auf regionsspezifische Daten oder Preisgestaltung.

Vorteile

- Vereinfachte Infrastruktur

- Hohe Erfolgsraten

- Einfache API-Integration

- Skalierbarkeit

Nachteile

- Potenzielle Kosten bei Skalierung

- API-Fokussiert (keine GUI)

Bewertung

Web Scraping als mächtiges Tool

Hier ist ein allgemeiner Überblick darüber, wie Web Scraping funktioniert:

- Abrufen von Webinhalten: Der Scraping-Prozess beginnt mit dem Senden von HTTP-Anfragen an den Server der Zielwebsite, um den HTML-Inhalt einer bestimmten Webseite abzurufen. Dies kann mit Programmiersprachen wie Python oder speziellen Scraping-Tools erfolgen.

- Parsen des HTML: Sobald der HTML-Inhalt abgerufen wurde, besteht der nächste Schritt darin, die relevanten Daten daraus zu extrahieren. Dabei wird das HTML-Dokument geparst, um spezifische Elemente wie Überschriften, Absätze, Tabellen oder Links zu identifizieren und zu lokalisieren.

- Datenextraktion: Nach der Identifizierung der gewünschten Elemente extrahiert der Scraper die erforderlichen Daten mit Techniken wie XPath, CSS-Selektoren, regulären Ausdrücken oder speziellen Bibliotheken wie Beautiful Soup in Python. Die extrahierten Daten können Texte, Bilder, Links oder andere Inhalte auf der Webseite umfassen.

- Speicherung und Verarbeitung der Daten: Die gescrapten Daten können in verschiedenen Formaten gespeichert werden, wie CSV, JSON oder einer Datenbank. Sobald sie gespeichert sind, können die Daten verarbeitet, analysiert oder in andere Systeme oder Anwendungen für die weitere Nutzung integriert werden.

Web-Scraping-Tools sollten verantwortungsbewusst und in Übereinstimmung mit den Nutzungsbedingungen und rechtlichen Einschränkungen der Website verwendet werden.

Web Scraping Tools FAQ

1. Was sind Web-Scraping-Tools?

Ein Web-Scraping-Tool ist eine Software oder eine Bibliothek, die den Web-Scraping-Prozess automatisiert. Diese Tools bieten Funktionen für das Abrufen, Parsen und Extrahieren von Daten aus Websites auf bequemere und effizientere Weise. Sie bieten häufig Funktionen wie Datenextraktion, Datentransformation, Planung, Proxy-Management und mehr.

2. Sind Web-Scraping-Tools legal?

Die Legalität des Web-Scrapings hängt von verschiedenen Faktoren ab, einschließlich der Nutzungsbedingungen der Website, der Gerichtsbarkeit und dem Zweck des Scrapings. Im Allgemeinen wird das Scraping öffentlicher Daten von Websites ohne Schadensverursachung oder Gesetzesverletzung als akzeptabel angesehen. Allerdings ist das Scraping privater oder urheberrechtlich geschützter Informationen, sensibler persönlicher Daten oder das Umgehen von Sicherheitsmaßnahmen in der Regel verboten. Es ist entscheidend, die Nutzungsbedingungen und geltenden Gesetze zu überprüfen und einzuhalten, bevor eine Website gescrapt wird.

4. Können Web-Scraping-Tools mit JavaScript-gerenderten Websites umgehen?

Einige Web-Scraping-Tools können mit JavaScript-gerenderten Websites umgehen, während andere möglicherweise zusätzliche Konfigurationen oder Tools benötigen. Tools wie Selenium, die Browser-Interaktionen automatisieren, werden oft verwendet, um Websites zu scrapen, die stark auf JavaScript für dynamisches Content-Loading angewiesen sind. Alternativ bieten einige Bibliotheken oder Frameworks, wie Puppeteer (für Node.js) oder Splash, JavaScript-Rendering-Funktionen, die speziell für Web-Scraping-Zwecke entwickelt wurden.

5. Gibt es Einschränkungen oder Herausforderungen bei Web-Scraping-Tools?

Web-Scraping-Tools können auf Einschränkungen oder Herausforderungen stoßen, abhängig von der Komplexität der Ziel-Website oder dem Datenvolumen, das gescrapt werden soll. Einige häufige Herausforderungen sind dynamische Websites, CAPTCHA-Schutz, IP-Blockierung, Rate-Limitierung oder Änderungen in der Website-Struktur. Fortgeschrittene Techniken wie rotierende Proxys, User-Agent-Spoofing oder die Implementierung von Verzögerungsmechanismen können helfen, diese Herausforderungen zu bewältigen.